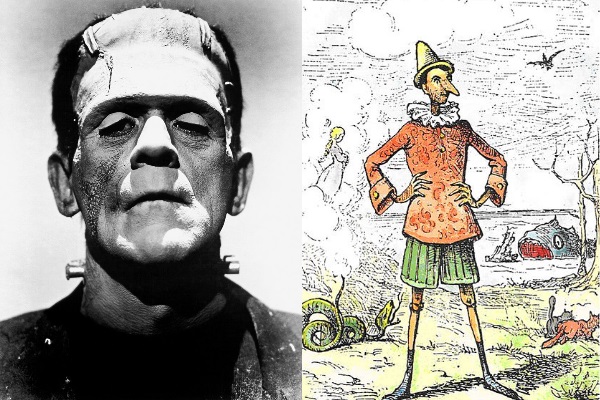

Google sta perdendo la memoria. O non gli è mai interessato averla?

Una notizia circolata sotto traccia nelle settimane passate potrebbe invece avere implicazioni dirompenti nel futuro della Rete: Google ha smesso di indicizzare i siti più vecchi di dieci anni.

Emersa solo in pochi siti mainstream (e guarda caso in nessuno italiano), la scoperta è stata fatta da Tim Bray, uno dei blogger della prima ora. Che nel tentativo di ritrovare alcuni suoi vecchi scritti, non è stato in grado di recuperarli attraverso Google.

Google perde la memoria o la abbandona?

Prima di pensare a un banale caso di incapacità, va detto che Bray è uno che sa il fatto suo: era già su Internet quando Google era agli albori e prima di esprimersi sulle pagine del suo blog ha fatto tutte le prove del caso, anche usando frasi esatte, ricerca per sito e così via.

Poteva farlo, perché era alla ricerca di suoi articoli di cui aveva il testo completo.

Sull’onda del lavoro di Bray, anche Marco Fioretti ha fatto una prova simile, con analoghi risultati. A questo punto le conferme iniziano a moltiplicarsi, e la notizia appare anche su altre fonti, per esempio boingboing.net.

Ma quindi Google non indicizza tutto il Web?

Per la verità, non lo ha mai fatto. Pensare che Google contenga tutte le pagine mai create è sempre stata una semplificazione. Sulla quale ci siamo adagiati tutti perché, fino a ora, nessuno si era mai posto il problema delle pagine datate. Nonostante il lavoro instancabile di realtà come The Internet Archive che senza troppo clamore tentano da anni di arginare questo fenomeno.

Insomma, finora nessuno si era mai accorto che il re era nudo

O forse, nessuno di autorevole si era preso la briga di andare a fondo. Ora appare chiaro che Google non ha alcun interesse nell’archiviare Internet di per sé, quanto nel fornire le risposte statisiticamente più commerciabili alle domande statisticamente più prevedibili. Insomma, a restituirci la parte vendibile del Web, trascurando tutto il resto.

Lo spiega perfettamente Tim Bray, con parole che provo a tradurre:

[Google] Si preoccupa di fornire buone risposte alle domande che contano per noi in questo momento. Se digito una domanda, anche qualcosa di complicato e oscuro, Google mi sorprende spesso con una risposta puntuale e precisa. Non hanno mai affermato di indicizzare ogni parola su ogni pagina.

Il mio modello mentale del Web è un archivio permanente e duraturo del patrimonio intellettuale dell’umanità. Perché questo sia utile, deve essere indicizzato, proprio come una biblioteca. Google apparentemente non condivide questo punto di vista.

Insomma. Google non è mai stato un archivio, (e per la verità non ha mai annunciato da nessuna parte di esserlo o volerlo essere).

Una scoperta che delinea il futuro di Google

Negli ultimi anni si fa un gran parlare della differenza fra motore di ricerca e motore di risposta. Google ha evidentemente una maggiore inclinazione per il secondo. Tuttavia questo secondo me è un problema, almeno per due motivi:

- L’umanità non è culturalmente pronta a capire la differenza fra un macro-assistente virtuale che dà buone risposte e un reale sistema biblioteconomico in grado di raccogliere, e restituire, tutto lo scibile

- al momento non esistono alternative al “qui e ora” voluto da Google. Anche se sembra che Bing e DuckDuckGo abbiano un approccio più sano nei confronti della memoria storica.

Certo, Esistono anche soluzioni specifiche per il Web “abbandonato”, come Archive.org e wiby.me, un motore di ricerca per “siti classici”. Ma manca la consapevolezza da parte degli utenti.

Chiedete a trenta persone che conoscete, ventinove vi risponderanno che su Google si trova tutto. E questo è un colossale problema.

Di fatto, lo scibile umano è in mano a un’azienda a fini di lucro

D’accordo, nella realtà non è propriamente così. Biblioteche e realtà virtuose come Archive esisteranno sempre. Ma quante sono, in percentuale, le persone che si accontentano dei risultati di Google e quante quelle che vanno oltre?

Parliamoci chiaro, chi si occupa di SEO lo sa più che bene: già essere fuori dalla prima pagina significa essere in una sorta di cimitero degli elefanti. Figuriamoci essere fuori da Google.

Il problema degli algoritmi si manifesta ancora una volta

Anche se ovviamente non c’è nessuna posizione ufficiale in materia, le ragioni di questa scelta sono ovvie: indicizzare le pagine web costa. E per un’azienda a fini di lucro, tutto quello che non è profittevole è dannoso. Fino qui nulla di sbagliato.

Ma cosa succederà se domani Google dovesse decidere di “tagliare” a cinque anni, o a sei mesi?

Sarebbe nel suo pieno diritto. Ma il patrimonio di conoscenza che potrebbe diventare irrecuperabile nel giro di pochi giorni potrebbe essere infinito. Poco importa se si tratta di fanfiction, meme sciocchi o opere d’arte. Rimane il problema che il lavoro di molti esseri umani potrebbe essere “oscurato” da una macchina nel giro di una notte.

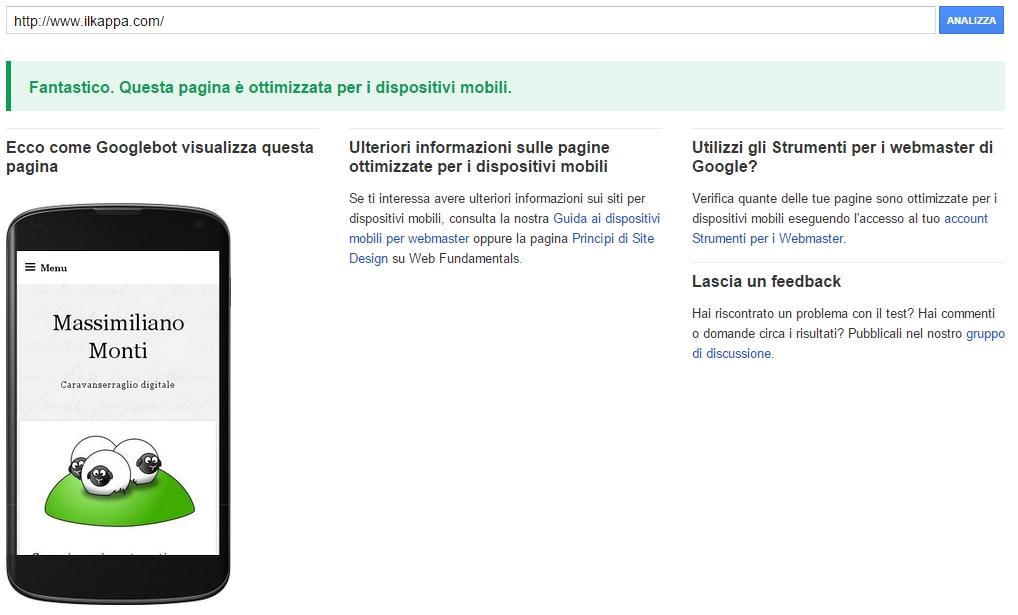

Cosa possiamo fare per evitare di essere dimenticati da Google?

A lunghissimo termine, e con una visione piuttosto utopica, darci da fare per un Web in cui non esistano monopoli di fatto, al contrario di quello che succede ora. Favorire la frammentazione, la diffusione di standard, il diritto all’interscambio dei propri dati, la liquidità delle piattaforme. Evitando, per quanto possibile, i servizi che sappiamo adottare politiche poco trasparenti e in ogni caso quelli che detengono qualche tipo di monopolio.

L’utopia massima sarebbe un sistema in cui ciascuno possiede i propri dati in via esclusiva, e le diverse piattaforme li interrogano e li mettono in relazione in modo controllato. Ma rassegnamoci: è impossibile, anche dal punto di vista tecnico, almeno con la tecnologia di ora. Quantomeno è impossibile in una logica di scala.

A medio e breve termine, ricordarci e ricordare che Google non è il solo motore di ricerca: Bing e DuckDuckGo stanno iniziando a essere valide alternative, ma anche l’europeo Qwant. Usarli può essere impervio oggi, ma potrebbe essere il primo tassello per una Rete meno schiava degli algorimi. O per lo meno ridurre la dipendenza da un numero limitatissimo di algoritmi.

Insomma, l’umanità dovrebbe sforzarsi di non fare con la tecnologia l’errore che ha fatto svariati millenni fa quando si è lasciata addomesticare dal grano.

Ne parlerò meglio in futuro, ma oggi sta accadendo esattamente questo: invece di essere l’informatica ad adattarsi alle necessità dell’umanità, l’umanità si sta piegando alle nevrosi del digitale. Invece di creare motori di ricerca realmente efficaci, ci sforziamo di scrivere nel modo che i motori di ricerca possono comprendere.

Invece di usare l’intelligenza artificiale per un riconoscimento realmente efficace della scrittura a mano o della parola scritta, ci deformiamo le articolazioni sulle tastiere. invece di avere sistemi che ci permettono di aggregare le informazioni in modo semplice ed efficace, passiamo le ore a ingolfarci di informazioni inutili sui social media.

In qualche modo, sembra che l’unica cosa che ci importi è faticare il meno possibile, fisicamente e intellettualmente, quando l’essenza stessa dell’essere umano dovrebbe spingerci verso il contrario.

Ci ricordiamo tutti la fine che hanno fatto gli eloi, vero?